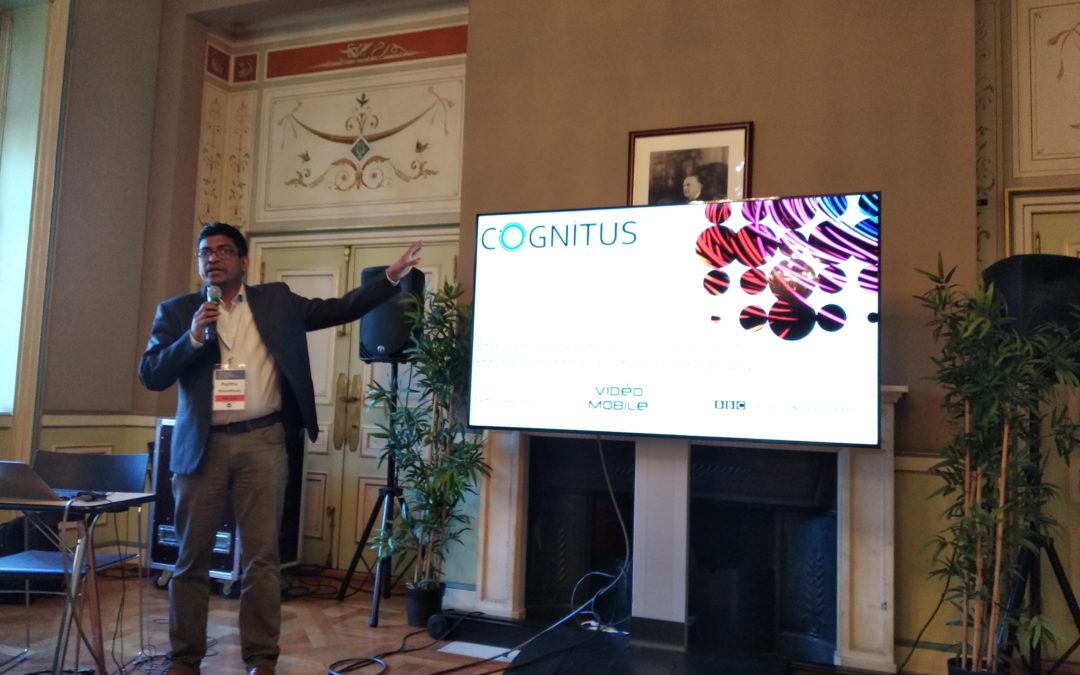

Rajitha Weerakkody, ingénieur en recherche et développement à la BBC a travaillé à la création de Cognitus. Ce vaste projet permet de stocker des photographies et des vidéos, de les modifier mais aussi de les améliorer visuellement. Il a accepté de nous parler des résultats de ces recherches conduites de janvier 2016 à décembre 2018 et auxquelles une cinquantaine de personnes ont participé.

En quoi consiste Cognitus précisément ?

L’une des technologies de Cognitus repère automatiquement des éléments de l’image pour créer des métadonnées. Par exemple, s’il y a un verre d’eau sur votre photographie, cela apparaîtra dans ses métadonnées. Techniquement, c’est une plateforme d’échange de fichiers totalement adaptable : l’utilisateur peut en moduler les fonctionnalités. Il y a d’un côté un site où vous pouvez stocker vos vidéos et photographies, et de l’autre une application. Ce système nous permet aussi d’améliorer la qualité des images.

Comment améliorez-vous la qualité ?

Nous utilisons le principe du machine learning. Nous ne sommes probablement pas les seuls à faire ça, mais nous le faisons bien (sourire). Imaginez que vous avez une image en basse qualité, mais que vous avez besoin d’une meilleure qualité, par exemple pour une diffusion à la télévision. L’algorithme de deep learning prend des centaines, des millions d’éléments de basse qualité et en ressort la meilleure qualité possible. Avec ces centaines, ces millions d’éléments, on trouve les différentes formules qui permettent de passer d’une photographie dont la résolution est basse, à une photographie dont la résolution est haute. Pour être efficace, il faut entraîner le programme, le nourrir d’un maximum d’images. C’est le principe du deep learning.

Mais comment est-il possible d’améliorer une image alors que certains pixels seront forcément manquant sur une vidéo de basse qualité ?

En fait, il faut comprendre la logique des modèles, des tendances. Imaginez-vous un plancher avec des blocs différents. En transférant au programme ces données, vous trouvez une formule. Si vous prenez des millions de photographies de planchers avec des formes et des blocs différents, vous arriverez à la meilleure formule. Ensuite, vous l’appliquez à quelque chose de nouveau, en l’occurrence un plancher différent mais similaire (un plancher tout noir ne fonctionnerait pas, par exemple). Si c’est bien similaire, on peut appliquer ce que nous avons appris grâce aux données et améliorer l’image.

Dans le futur les images de mauvaise qualité vont s’améliorer ?

Nous ne saurons vraiment qu’en entraînant ce système. Ça ne sera pas parfait sauf s’il est entraîné sur le type d’images qu’on lui demande de gérer. Et il est impossible d’entraîner les assistants pour absolument tout.

Est-ce que ces recherches aboutiront effectivement sur une application ?

Nous n’avons pas de plan défini pour le moment. C’est toujours un projet de recherches même s’il est fini. Nous ne savons pas encore si quelqu’un va acheter le projet et si oui, qui. Nous avons fait des essais et nous en ferons encore probablement, c’est tout ce que je peux dire. C’est plutôt commun avec les projets de recherche.

Propos recueillis par Diane Regny

Commentaires récents